Linux集群构建是处理大数据任务的关键步骤,它通过将多台计算机连接起来,形成一个统一的计算资源池,从而提升数据处理能力和系统稳定性。

在构建Linux集群时,硬件选择和网络配置至关重要。服务器应具备足够的CPU、内存和存储空间,以应对高并发的数据处理需求。同时,高速网络设备能够确保节点之间的数据传输效率。

软件层面,操作系统的选择和优化同样重要。使用稳定的Linux发行版,如CentOS或Ubuntu,可以提供良好的兼容性和安全性。•安装必要的工具链,如Hadoop或Spark,有助于实现分布式计算。

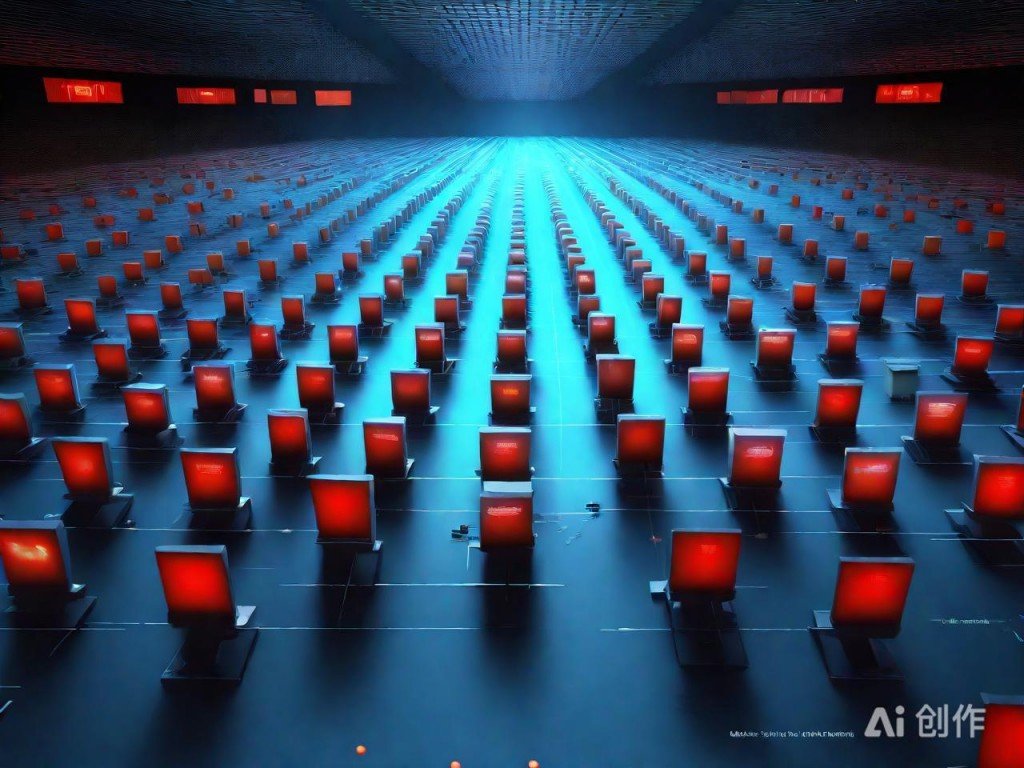

AI绘图,仅供参考

集群管理工具如Kubernetes或Ansible能够简化节点的部署和维护工作。这些工具支持自动化配置、监控和故障恢复,显著降低运维复杂度。

数据备份与容错机制也是不可忽视的部分。通过设置冗余存储和定期备份,可以有效防止数据丢失,并在出现故障时快速恢复服务。

最终,持续优化集群性能是保障大数据任务高效运行的重要环节。通过分析日志、调整资源配置和更新软件版本,可以不断提升系统的整体表现。